AI在以太网、光模块、InfiniBand中的创新融合

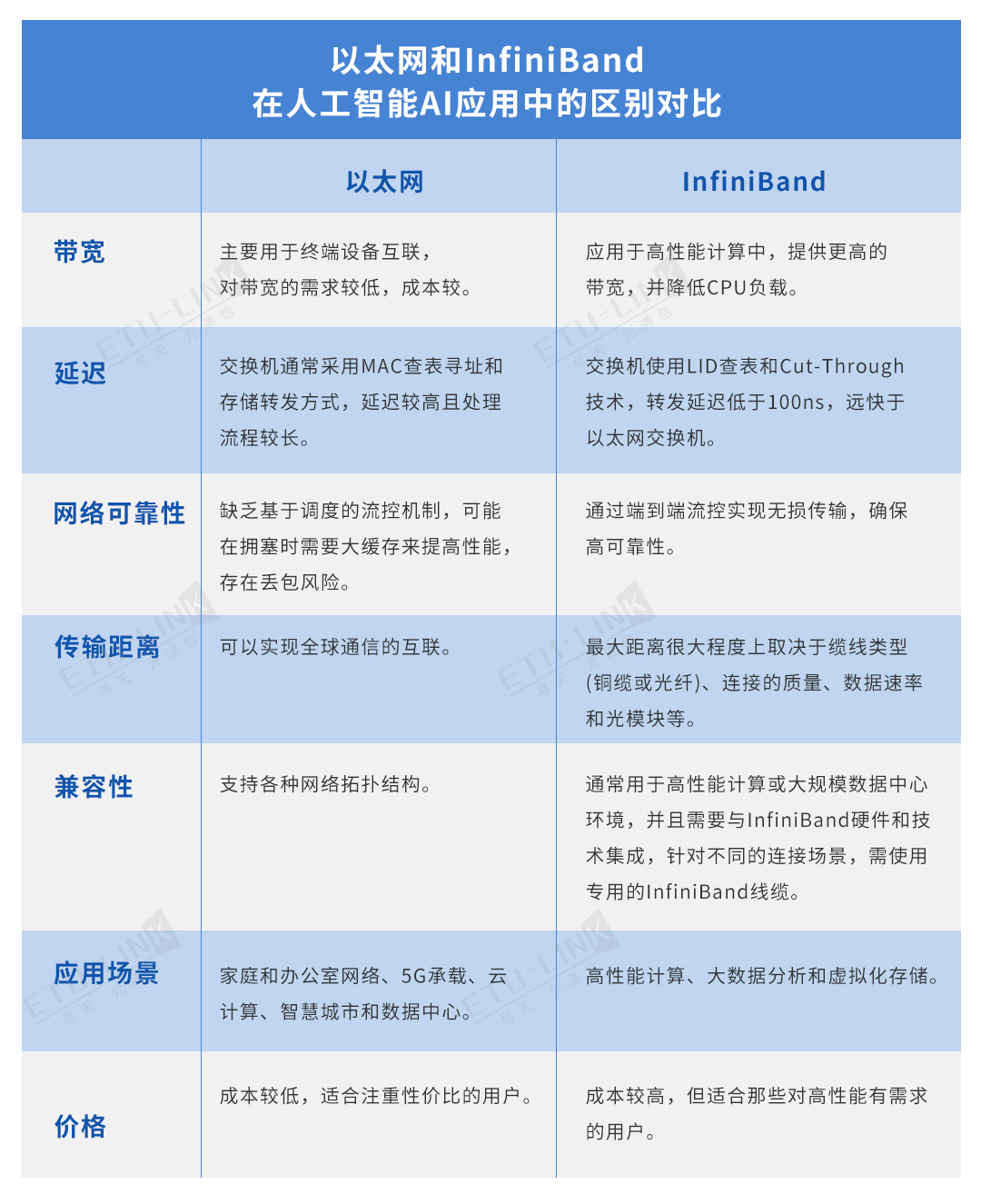

随着人工智能(AI)技术的迅猛发展,尤其是生成式AI的兴起,数据中心对计算和网络资源的需求达到了前所未有的高度。以太网(Ethernet)和InfiniBand作为两种主流网络技术,正通过不断创新和融合,为AI应用提供强大的加速能力。

以太网的演进、光模块的集成与AI加速

以太网自诞生以来,便以其简单的设计、低成本和广泛的应用成为局域网和广域网的主导技术。近年来,为了满足AI和高性能计算(HPC)对延迟和带宽的更高要求,以太网不断演进,引入了多项新技术。其中,RDMA over Converged Ethernet(RoCE)技术尤为关键,它允许在以太网上实现远程直接内存访问(RDMA),显著降低了网络通信的延迟,还通过集成高速光模块,如400G/800G OSFP等,极大地提升了数据传输速率与效率。

在AI应用中,RoCE技术使得数据可以直接在GPU之间传输,无需经过CPU处理,从而大大提高了数据传输效率和训练速度。此外,高端以太网交换机和网卡具备强大的拥塞控制、负载均衡功能和RDMA支持,能够扩展到比传统网络更大的规模,满足大规模AI模型训练的需求。

InfiniBand:专为高性能计算设计

InfiniBand(无限带宽)是一种专为高性能计算设计的网络通信标准,以其高带宽、低延迟和可靠的数据传输能力而闻名。在AI领域,InfiniBand的优势尤为明显。它支持RDMA技术,允许数据在两台计算机的内存之间直接传输,从而减少了CPU的负载,提高了数据传输效率。

InfiniBand的另一个重要特性是其高度可扩展性。它支持大量的连接节点,可以构建复杂的网络拓扑结构,如树形、网状等,为AI应用提供了灵活的网络架构。此外,InfiniBand还具备卓越的端到端拥塞控制机制,能够在网络拥堵时自动调整数据流,确保数据传输的稳定性和高效性。

技术融合与性能提升

随着AI技术的不断发展,以太网和InfiniBand之间的界限逐渐模糊。以太网通过引入RoCE及高性能光模块等新技术,不断提升其在高性能计算领域的竞争力;而InfiniBand也在不断优化其成本效益和易用性,以吸引更广泛的用户群体。这种技术融合的趋势预示着未来数据中心网络将更加多样化和高效。

在AI应用中,以太网和InfiniBand的结合更是实现了性能的显著提升。通过部署混合网络架构,数据中心可以根据实际需求灵活选择网络技术,为AI模型训练提供最优的网络环境。例如,在训练大型AI模型时,可以采用InfiniBand网络来确保低延迟和高带宽的数据传输;而在处理一般数据流量时,则可以使用以太网来降低成本和提高灵活性。

AI在以太网和InfiniBand中的加速是数据中心网络技术发展的一个重要方向。通过不断创新和融合,这两种技术正在为AI应用提供更加强大和高效的网络支持。未来,随着AI技术的进一步发展和应用场景的不断拓展,我们有理由相信,以太网、光模块和InfiniBand将在AI领域发挥更加重要的作用,推动数据中心网络向更高速度、更低延迟和更强大功能的方向前进。

上一个 :

基于100G-PAM4技术的LinkX 线缆下一个 :

光学器件在人工智能集群中不断演变的作用新博客

微信公众号